Cloaking SEO : danger ou opportunité ? Comprendre cette technique black hat

Le cloaking SEO, cette méthode controversée, représente-t-elle réellement une opportunité ou un danger pour votre référencement ? Voyons comment cette technique de black hat influence votre positionnement sur Google et les moteurs de recherche, et pourquoi il importe d’en saisir les implications stratégiques. Cet article explore le cloaking sous divers angles, des techniques d’obfuscation aux pratiques alternatives pour un référencement naturel pérenne. Êtes-vous prêt à explorer les arcanes des stratégies SEO les plus opaques du web ?

Sommaire

- Le cloaking en SEO : comprendre les fondamentaux

- Risques et conséquences du cloaking

- Les formes techniques du cloaking

- Stratégies SEO éthiques alternatives

- Cloaking et évolutions algorithmiques

- Enjeux juridiques et conformité

- Cas pratiques remarquables

Le cloaking en SEO : comprendre les fondamentaux

Le cloaking SEO consiste à montrer un contenu différent aux robots d’indexation et aux internautes.

Voici les principales approches employées :

- User-Agent : Le site détecte le navigateur utilisé. Si c’est un robot, il affiche une page optimisée pour le référencement, sinon la version standard.

- Adresse IP : L’origine de la connexion est analysée. Les adresses connues des moteurs déclenchent l’affichage d’un contenu spécifique.

- JavaScript : Le navigateur exécute des scripts qui modifient dynamiquement ce que voit l’internaute, tandis que les robots reçoivent une version statique différente.

- En-tête HTTP Accept-Language : La langue configurée dans le navigateur détermine quelle version du site sera affichée.

Ces méthodes créent une dualité entre l’internaute et le moteur. Le contenu devient alors un miroir à deux faces.

En pratique, c’est le serveur qui joue ici un rôle central. Il adapte sa réponse selon qu’il identifie un navigateur humain ou un crawler. Certains tentent ainsi d’afficher des mots-clés stratégiques uniquement pour les robots, altérant l’expérience réelle des internautes.

Signalons que cette approche est officiellement classée comme black hat. Les moteurs sanctionnent systématiquement les pages utilisant cette pratique, car elle fausse le principe de référencement naturel. L’expérience utilisateur doit rester alignée avec ce que perçoivent les algorithmes.

Un point mérite attention : la frontière devient floue avec certaines techniques d’affichage conditionnel légitimes. Tout dépend finalement de l’intention derrière la manipulation du contenu.

Risques et conséquences du cloaking

Les sanctions algorithmiques et manuelles de Google s’avèrent souvent sévères. Recourir à cette pratique, c’est risquer de lourdes conséquences pour son référencement naturel.

| Type de Pénalité | Description | Conséquences sur le Référencement |

|---|---|---|

| Déclassement | Le site apparaît moins haut dans les resultats de recherche. Peut être manuel (« position 6 penalty », « minus 30 », « minus 60 ») ou algorithmique. | Diminution du trafic organique due à une visibilité réduite. |

| Désindexation | Suppression complète du site de l’index de Google. Peut être partielle ou totale. | Invisibilité totale dans les resultats de recherche. Perte drastique de trafic organique. |

| Origine de la Pénalité | Peut être algorithmique (appliquée automatiquement par Google Panda) ou manuelle (infligée après examen par une équipe de Google). | Varie selon la sévérité de la pénalité et l’infraction commise. |

| Gravité | Le déclassement est moins sévère que la désindexation. | La désindexation a un impact beaucoup plus important et immédiat sur la visibilité et le trafic. |

| Cloaking | Ces manipulations peuvent déclencher des sanctions sévères, qu’elles soient automatiques ou humaines. | Impact direct sur le positionnement et la visibilité du site web. |

L’enjeu économique pour les plateformes sanctionnées n’est pas négligeable. Une pénalité peut faire chuter le trafic organique, ce qui affecte directement les revenus. Les internautes risquent alors de moins découvrir vos offres via leur navigateur habituel, réduisant vos conversions et votre notoriété. Signalons que récupérer son référencement après sanction demande souvent des mois d’efforts coûteux. Un e-commerce désindexé verrait ses ventes s’effondrer littéralement du jour au lendemain.

Mais attention : au-delà des algorithmes, cette pratique altère durablement la confiance des internautes. Lorsqu’un navigateur affiche une version différente de ce qu’attend l’internaute, l’expérience utilisateur en pâtit immédiatement. Google privilégie désormais les pages qui offrent une expérience cohérente entre ce qui s’affiche dans les résultats et ce que voit réellement le visiteur.

Les formes techniques du cloaking

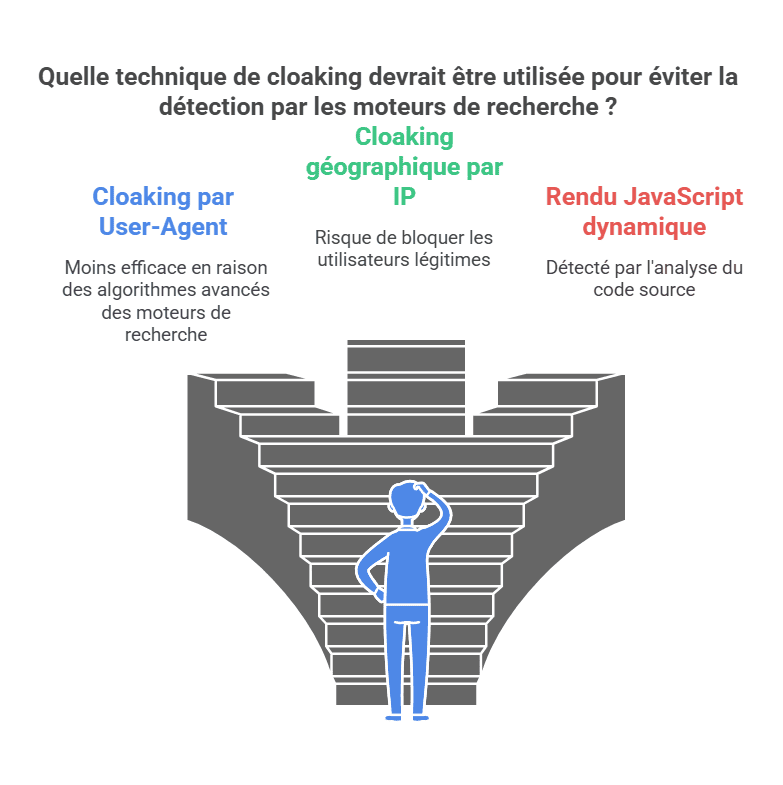

Cloaking par User-Agent

Identifier les robots via les en-têtes HTTP reste une méthode courante, mais de moins en moins fiable. Pourquoi ? Parce que les navigateurs modernes et les outils d’indexation mobile-first complexifient la tâche.

Cette approche perd en efficacité face aux progrès des algorithmes. Prenons Googlebot : il analyse désormais le rendu côté serveur, comparant systématiquement ce que voit l’internaute avec la version destinée au robot. Les différences de contenu entre mobile et desktop sautent aux yeux des moteurs, déclenchant souvent des pénalités. Signalons que les mises à jour régulières des algorithmes rendent cette pratique particulièrement risquée aujourd’hui.

Exemple concret : un script serveur qui modifie l’affichage selon l’user-agent détecté. Mais attention, les navigateurs récents brouillent souvent ces pistes…

Cloaking géographique par IP

Certains tentent de jouer avec la géolocalisation via les adresses IP. Une stratégie délicate, car les moteurs croisent désormais leurs données avec des bases IP sophistiquées.

La difficulté vient surtout des infrastructures cloud modernes. Avec les CDN et l’hébergement partagé, une même IP peut servir plusieurs sites. Quant aux solutions de contournement (proxies, VPN), elles compliquent l’expérience des internautes légitimes sans garantir l’indétectabilité. Paradoxalement, cette méthode génère parfois l’effet inverse : des visiteurs réels se voient afficher un contenu inadapté à leur région.

Risque majeur : le blocage accidentel d’internautes authentiques. Un prix trop élevé pour une efficacité incertaine.

Autres variantes techniques

Le rendu JavaScript dynamique représente une autre piste exploitée. Mais là encore, les moteurs ont développé des parades.

Googlebot excelle désormais dans l’analyse du code source, comparant version brute et contenu affiché dans le navigateur. Les comportements suspects – comme un changement radical de texte après chargement – alertent immédiatement les systèmes. Les mises à jour fréquentes des algorithmes ciblent spécifiquement ces manipulations, rendant le jeu dangereux à moyen terme.

En pratique, toute divergence entre l’expérience réelle des internautes et ce que perçoit le robot devient un signal d’alarme. Les systèmes d’IA traquent même les micro-variations dans les résultats de recherche.

Détection et prévention

Auditer régulièrement son site reste la meilleure parade. Des outils comparatifs analysant l’affichage côté serveur et navigateur détectent les écarts involontaires.

La configuration technique joue un rôle clé : serveurs bien sécurisés, CMS à jour, monitoring des logs. Une bonne hygiène numérique limite les risques de manipulation accidentelle. Pour les internautes comme pour les moteurs, l’objectif reste le même : garantir une expérience cohérente et naturelle sur chaque page.

En conclusion, miser sur la transparence et l’authenticité du contenu s’avère toujours plus payant à long terme. Les techniques artificielles finissent généralement par se retourner contre leur utilisateur.

Stratégies SEO éthiques alternatives

Optimisation du contenu

Les méthodes white hat renforcent la pertinence sémantique de vos publications. Le SEO éthique désigne l’ensemble des bonnes pratiques recommandées par Google, visant à améliorer les plateformes via des approches durables. Ces stratégies privilégient l’internaute plutôt que les algorithmes. L’enjeu ici, c’est de rendre votre site plus visible grâce à un matériel qualitatif et des liens organiques. Produire des ressources utiles et engageantes devient un levier clé pour obtenir des backlinks naturels. Parmi les techniques courantes, on trouve l’ajustement des mots-clés stratégiques et l’amélioration de l’architecture du site.

Intégrer des mots-clés de manière fluide et enrichir le contexte boostent votre référencement. La clé ? Utiliser ces termes avec parcimonie, comme le ferait un rédacteur humain. Varier les expressions et maintenir une cohérence globale évite la surcharge artificielle. Pour les ancres de lien, mieux vaut opter pour des formulations courtes plutôt que des phrases entières. Signalons que la qualité prime : un contenu bien structuré, avec des titres parlants et des descriptions précises, marque des points auprès des navigateurs comme des robots.

Optimisation technique

Améliorer le temps de chargement et l’adaptabilité mobile reste primordial pour l’expérience utilisateur. Ce volet technique constitue l’un des trois piliers SEO avec le contenu et les backlinks. Il s’agit ici de paramétrer votre plateforme pour qu’elle soit parfaitement lisible par les crawlers. Trois axes majeurs se dégagent : performances, accessibilité et interprétation des balises. Une gestion fine des métadonnées et des schémas structurés facilite le travail des moteurs tout en fluidifiant la navigation.

En pratique, cela passe par exemple par l’optimisation des images pour afficher rapidement les pages même sur connexion limitée. Les internautes mobiles représentent désormais la part majoritaire du trafic : un site réactif sur tous les navigateurs devient incontournable. Notons que chaque amélioration technique renforce indirectement le positionnement global.

Netlinking responsable

Obtenir des liens entrants via des partenariats ciblés reste la méthode la plus pérenne. Plutôt que de chasser la quantité, privilégiez les backlinks provenant de sources autoritaires dans votre domaine. Une collaboration avec des médias locaux ou des institutions éducatives apporte souvent plus de valeur qu’une centaine de liens artificiels.

Attention cependant : une veille active s’impose pour détecter les liens toxiques. Des outils comme Google Search Console aident à identifier ces risques. Rappelons qu’un profil de liens varié et contextuel influence positivement votre référencement naturel. Enfin, n’oubliez pas que chaque lien entrant devrait avant tout apporter une réelle plus-value à l’internaute qui le clique.

Cloaking et évolutions algorithmiques

Impact des mises à jour Google

L’historique des mises à jour contre le cloaking montre une évolution significative. Cette méthode trompeuse relève du spam SEO en affichant des informations distinctes aux outils de recherche et aux internautes. Google a réagi en lançant des mises à jour spécifiques comme celle de juin 2024, suivie d’une autre en décembre 2024. Ces mesures renforcent la lutte contre les manipulations dans les , sanctionnant sévèrement les pages employant des procédés illicites. En réalité, le cloaking accompagne presque l’histoire des navigateurs web. Bien qu’encore pratiqué, il représente aujourd’hui un risque majeur pour les éditeurs.

L’intégration d’IA comme RankBrain ou MUM transforme la détection des abus. Ces systèmes permettent à Google d’interpréter plus finement le naturel d’une page, tout en observant le comportement des internautes. L’analyse des interactions utilisateur devient déterminante pour repérer les incohérences entre ce qu’affiche le navigateur et ce que perçoit l’internaute. Notons que les mises à jour récentes évaluent particulièrement l’utilité concrète des informations proposées, un critère clé pour l’expérience globale.

Avenir du cloaking

Les progrès technologiques rendent son utilisation toujours plus périlleuse. Si certaines techniques tentent de contourner les filtres, les capacités d’analyse automatisée réduisent progressivement leur efficacité. Les propriétaires de site s’exposent désormais à des sanctions rapides et parfois irréversibles. Pour vérifier d’éventuelles manipulations, une première approche consiste à examiner directement le code source via des navigateurs spécialisés – une méthode accessible même aux non-experts.

L’évolution probable du phénomène semble orientée vers des hybridations plus subtiles entre contenu visible et masqué.

Veille proactive

Plusieurs solutions permettent de surveiller son positionnement et le trafic organique.

Anticiper les modifications algorithmiques nécessite une observation régulière des tendances du référencement. Une expérience approfondie montre l’importance d’adapter rapidement sa stratégie éditoriale.

Enjeux juridiques et conformité

Cadre légal européen

Le RGPD et les directives e-commerce s’imposent comme des références incontournables. Ce règlement européen encadre strictement l’utilisation des données personnelles, particulièrement dans le secteur du commerce en ligne. Les entreprises doivent obtenir l’accord explicite des internautes avant toute collecte d’informations, tout en garantissant une transparence absolue dans leurs politiques de confidentialité. Signalons que les sanctions pour non-respect peuvent entraîner des sanctions financières importantes.

La transparence des pratiques éditoriales constitue un autre impératif. Les pages web doivent afficher clairement leur méthodologie de création de contenu, surtout lorsqu’il s’agit d’optimiser le référencement. Le cloaking, qui présente des informations différentes au navigateur et aux internautes, reste strictement prohibé par les régulateurs. Cette pratique, considérée comme trompeuse, entraîne systématiquement des pénalités de la part des moteurs de recherche.

Respect des guidelines

La Search Console s’avère indispensable pour vérifier sa conformité aux exigences techniques. Cet outil permet notamment de recevoir des alertes directes sur d’éventuels manquements aux guidelines, de surveiller les sanctions appliquées au site, et de demander un réexamen après correction des anomalies. Voyons comment elle facilite le suivi des actions manuelles liées au référencement non naturel.

La gestion post-pénalité demande une approche méthodique. Elle implique généralement une audit complet du site, une correction des anomalies détectées, puis une requête formelle accompagnée de preuves de conformité.

Défense contre les attaques

La protection contre le plagiat nécessite une vigilance constante. Les internautes attendent une expérience unique et personnalisée, ce qui rend cruciale la détection des duplications frauduleuses.

Plusieurs solutions techniques existent pour sécuriser son site. Les outils anti-plagiat comme Copyscape analysent le navigateur pour repérer les copies, tandis que des mesures de sécurité avancées bloquent les tentatives d’intrusion. En pratique, une configuration adéquate du serveur permet de afficher des contenus différenciés tout en restant conforme aux bonnes pratiques.

Signalons enfin l’importance des mises à jour régulières. Elles permettent d’afficher une expérience utilisateur cohérente tout en maintenant des standards techniques élevés, essentiels pour préserver la confiance des internautes.

Cas pratiques remarquables

L’analyse de plateformes sanctionnées et leur processus de récupération s’avèrent riches d’enseignements. Un constat s’impose : les erreurs commises éclairent souvent les bonnes pratiques à adopter.

Plusieurs enseignements ressortent pour les professionnels du référencement. L’étude de projets web pénalisés pour cloaking révèle surtout une réalité – les raccourcis trop audacieux finissent toujours par se payer. Prenons l’exemple de ces sites ayant tenté de duper les algorithmes avec du texte masqué ou des redirections douteuses : leur restauration dans les résultats nécessite généralement une cure de transparence radicale. Le chemin vers la réhabilitation passe systématiquement par l’alignement entre ce que perçoit l’internaute dans son navigateur et ce qu’analysent les robots. Concrètement, cela implique de revoir l’intégralité des pages concernées, parfois même l’architecture technique. Signalons qu’un audit minutieux permet souvent d’identifier des incohérences involontaires entre les versions mobile et desktop. La leçon primordiale ? Privilégier en permanence l’expérience réelle des utilisateurs. Les cas analysés montrent que les contenus optimisés de manière excessive finissent par nuire à la crédibilité globale. À l’inverse, un référencement naturel basé sur des informations claires et accessibles tend à pérenniser les positions acquises. Preuve à l’appui : un e-commerce sanctionné a retrouvé sa visibilité après avoir simplifié son architecture et harmonisé le contenu affiché selon le support utilisé. L’effort principal porta sur l’adaptation aux attentes des internautes plutôt que sur le contournement des algorithmes. Une approche qui, finalement, profite à tous les acteurs du web.

Le cloaking SEO, une pratique risquée, met en péril votre référencement à long terme. Rappelons que seule l’optimisation éthique, alignée sur les directives de Google, garantit une visibilité naturelle et durable. Mieux vaut agir sans attendre : l’avenir du web récompense ceux qui privilégient la transparence.